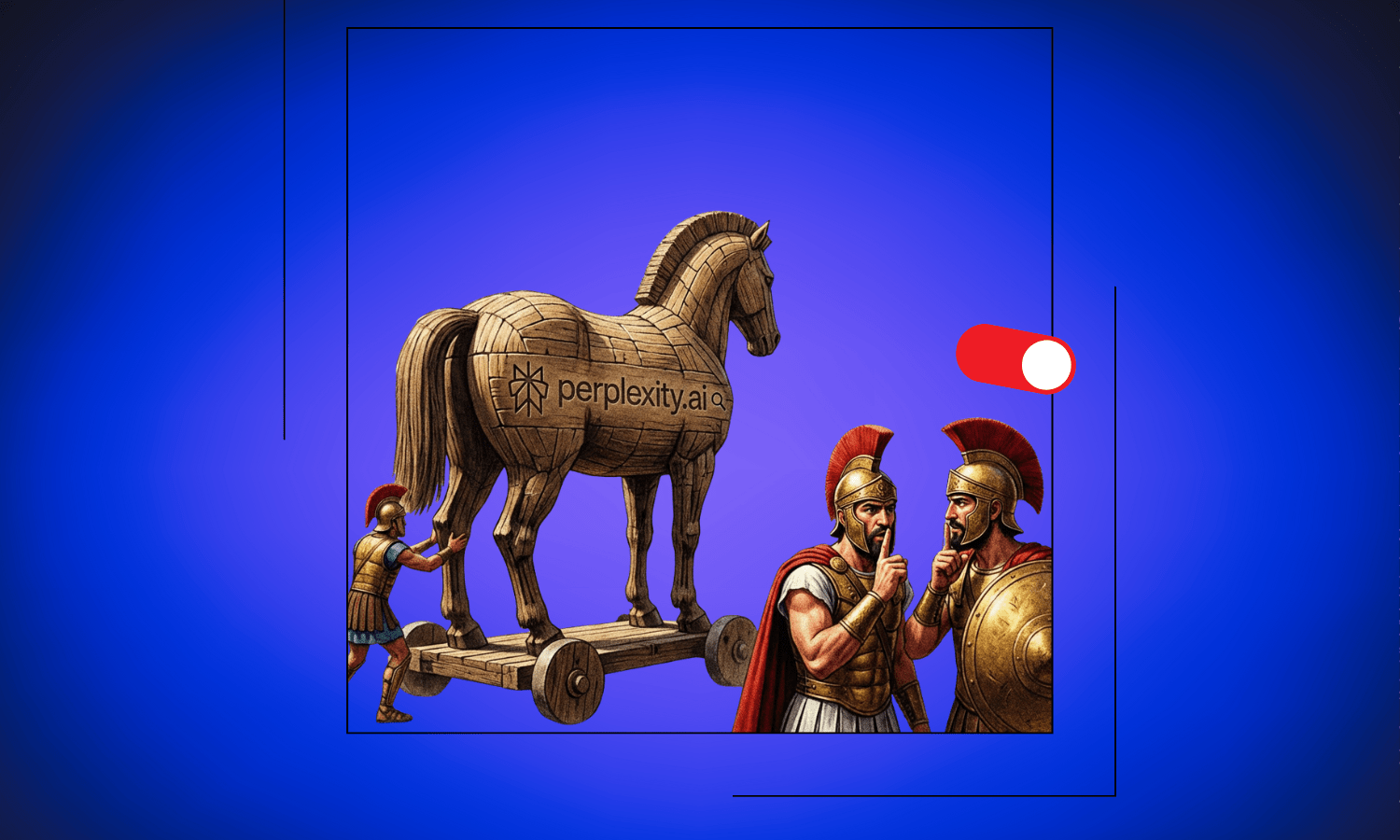

Perplexity PRO-Geschenk von Mobilfunkanbietern ist ein Trojanisches Pferd getarnt als kostenloser KI-Assistent – So schützt du dich sofort

Millionen haben dieses kostenlose Perplexity PRO-Geschenk ihrer Mobilfunkanbieter angenommen – und unwissentlich ihre sensibelsten Geheimnisse in eine KI-Trainingsmaschine gefüttert

Das Risiko beim “kostenlosen” Perplexity-Upgrade Kurzer Überblick

Wenn du einer der Millionen bist, die kürzlich ein kostenloses Perplexity PRO-Abonnement über ihren Mobilfunkanbieter erhalten haben: Glückwunsch. Du bist gerade Teil einer der aggressivsten Datensammelkampagnen der KI-Branche geworden. Während Anbieter wie Airtel (Indien), Deutsche Telekom (Deutschland), Telefónica (Spanien), Bouygues Telecom (Frankreich), SK Telecom (Südkorea), Taiwan Mobile (Taiwan), Singtel (Singapur), Tango (Luxemburg) und andere dies als Premium-Vorteil bewerben, gibt es einen versteckten Haken: Standardmäßig werden deine privatesten Gedanken genutzt, um die KI-Modelle von Perplexity zu trainieren.

Perplexity expandiert nicht einfach nur. Das Unternehmen nistet sich systematisch in die Telekommunikationsinfrastruktur auf allen Kontinenten ein. Von Airtel in Indien bis Tango in Luxemburg, von Telefónica in Spanien bis Taiwan Mobile – das Unternehmen hat Partnerschaften mit Anbietern geschlossen, die hunderte Millionen von Nutzern bedienen.

Das Angebot klingt verlockend: kostenlose PRO-Funktionen inklusive unbegrenzter Suchanfragen, fortschrittlicher KI-Modelle und Bildgenerierung.

Aber hier ist das, was sie nicht fettgedruckt bewerben: Jede Suchanfrage, die du stellst, jede Geschäftsidee, die du brainstormst, und jede sensible Frage, die du tippst, füttert standardmäßig ihre Trainings-Pipeline. Das ist kein Versehen. Es ist das Geschäftsmodell.

Die globale Datensammel-Strategie

Diese Partnerschaften ermöglichen es Perplexity, die herkömmlichen Kosten für die Neukundengewinnung zu umgehen. Anstatt dich davon überzeugen zu müssen, dich anzumelden, wird der Dienst einfach in das Paket gebündelt, für das du ohnehin schon bezahlst.

Das Ergebnis? Ein massiver Zustrom an Nutzerdaten. Überlege mal, was du tatsächlich mit einem KI-Assistenten teilst:

- Geschäftsstrategien

- Gesundheitssorgen

- Finanzplanung

- Persönliche Beziehungen

- Karriereängste

Das sind keine beiläufigen Websuchen. Es sind deine ungefilterten Gedanken, oft aufschlussreicher als das, was du engen Freunden erzählen würdest. Diese Daten einem Unternehmen zu übergeben, das standardmäßig damit trainiert, zeigt deutlich, wo dessen Prioritäten liegen.

So gehst du dagegen vor: Der versteckte Schalter

Wenn du dein “kostenloses” PRO-Abonnement aktivierst, schaltet Perplexity still und leise das KI-Datentraining ein. Keine deutliche Warnung, kein Einwilligungsdialog, nur eine vergrabene Einstellung, die einfach annimmt, dass du damit einverstanden bist, dass deine privaten Konversationen zu Trainingsdaten werden.

So schützt du deine zukünftigen Chats in Perplexity:

- Gehe auf perplexity.ai und klicke auf dein Profilbild.

- Wähle Einstellungen aus dem Menü.

- Finde KI-Datenaufbewahrung in den Einstellungen.

- Schalte dies sofort auf AUS. So, dass der Schieberegler nach links zeigt und grau ist.

Das sollte eigentlich die Standardeinstellung sein. Die Tatsache, dass sie es nicht ist, verrät alles darüber, wie Perplexity Nutzerprivatsphäre im Vergleich zur Datenbeschaffung bewertet.

Warum ein “Opt-out” nicht reicht

Selbst nach dem Deaktivieren des Datentrainings ist es riskant, Perplexity wirklich sensible Informationen anzuvertrauen. Das Unternehmen hat bereits gezeigt, dass Wachstum und Datensammlung wichtiger sind als einfache ‘Datenschutz’-Prinzipien. Ihre Partnerschaftsstrategie spricht Bände. Sie verbreiten sich über Mobilfunkanbieter, die den Dienst bündeln können, ohne dass sich die Nutzer aktiv dafür entscheiden. Dieser Ansatz priorisiert Skalierung und Datenvolumen über alles andere.

Der Opt-out-Schalter bietet juristische Absicherung, keinen echten Datenschutz. Sobald du sensible Informationen geteilt hast, kannst du das Teilen nicht rückgängig machen. Du kannst nicht überprüfen, was bereits in die Trainings-Pipelines eingeflossen ist, bevor du diese Einstellung entdeckt hast. Und wer weiß, ob sie den Schalter überhaupt respektieren.

Perplexity ist bekannt dafür, es mit dem Datenschutz nicht so genau zu nehmen

Wir haben ihre vergangenen Patzer bereits aufgedeckt – tatsächlich waren wir die Ersten, die eine kritische Datenschutzlücke enthüllten, durch die hochgeladene Bilder von Nutzern öffentlich für jeden einsehbar waren. Sie haben dieses spezielle Problem zwar behoben, bleiben aber gleichzeitig stark abhängig von Big-Tech-Anbietern wie Amazon, Cloudflare und Google.

Ein Beispiel: Wenn du eine Frage stellst, ruft die Seite Favicons über Google ab – und sendet dabei deine Geräteinfos und IP-Adresse direkt nach Mountain View. Sie verlassen sich zudem vollständig auf Amazon Web Services. Wenn AWS ausfällt, fällt Perplexity aus. Wenn Cloudflare ausfällt, rate mal? Dann fällt auch Perplexity aus.

Es geht nicht nur um Zuverlässigkeit; es geht um Privatsphäre. Perplexity teilt ständig Hunderte von Datenpunkten über dich (wie deine IP-Adresse, den Gerätetyp, die Browserversion und mehr) mit diesen Drittanbietern. Es ist eigentlich schwer zu glauben, dass Milliarden von Dollar in ein Unternehmen mit einer solchen Struktur fließen. Es sei denn natürlich, man realisiert, dass Daten im Zeitalter der KI mehr wert sind als Gold.

Der wahre Preis von “Kostenlos”

Die Partnerschaften von Perplexity mit den Telekommunikationsanbietern sind aus Wachstumsperspektive brillant. Sie haben einen Weg gefunden, massive Nutzerbasen ohne traditionelle Marketingkosten zu erreichen, indem sie ihren Service als Premium-Vorteil positionieren. Aber für die Nutzer, insbesondere diejenigen, die den Schalter für das Datentraining nicht entdecken, ist der Preis eine als Assistenz getarnte Überwachung.

Dein KI-Assistent sollte ein Werkzeug sein, das dein Denken erweitert, kein Überwachungsmechanismus, der es monetarisiert. Bevor du deine sensibelsten Fragen in Perplexity eingibst, selbst mit deaktiviertem Training, frage dich folgendes: Vertraue ich einem Unternehmen, das dieses System so konzipiert hat, dass Datensammlung der Standard ist?

Die datenschutzfreundliche Alternative

Wenn du Wert darauf legst, dass deine privaten Gedanken auch privat bleiben, brauchst du einen KI-Assistenten, der mit Datenschutz als Kernprinzip gebaut wurde, und nicht als nachträglicher Gedanke, der in den Einstellungen versteckt wird. Lösungen wie CamoCopy beweisen, dass man für Datenschutz nicht auf KI-Fähigkeiten verzichten muss.

Diese Dienste liefern dieselbe konversationelle KI-Leistung, dieselbe Fähigkeit, komplexe Anfragen zu verarbeiten und Erkenntnisse zu generieren, aber mit einem fundamentalen Unterschied: Deine Daten bleiben deine. Keine Trainings-Pipelines, keine Konzern-Analyse deiner Denkmuster, kein Risiko, dass deine sensiblen Anfragen zum Datensatz von jemand anderem werden.

Wichtige Schlussbemerkung

Teile diesen Artikel unbedingt mit Freunden oder Kollegen – denn diese Standardeinstellung zur Datensammlung betrifft tatsächlich alle PRO-Nutzer, also auch für Personen die für PRO bezahlen und ist nicht nur auf die Empfänger des Geschenks der Mobilfunkanbieter beschränkt. Zeig ihnen die Schritte oben, damit sie ihre Chats schützen können, falls sie Perplexity weiter nutzen wollen – oder wechselt direkt zu CamoCopy, wenn ihr einen KI-Assistenten sucht, der sich nicht durch eure Daten finanziert.