Was ist Schatten-KI? Warum sie ein großes Problem ist und wie man es löst

Von ChatGPT bis Gemini – KI-Tools verändern die Arbeit. Aber zu welchem Preis für Datenschutz und Sicherheit?

Was ist Schatten-KI? Kurze Definition

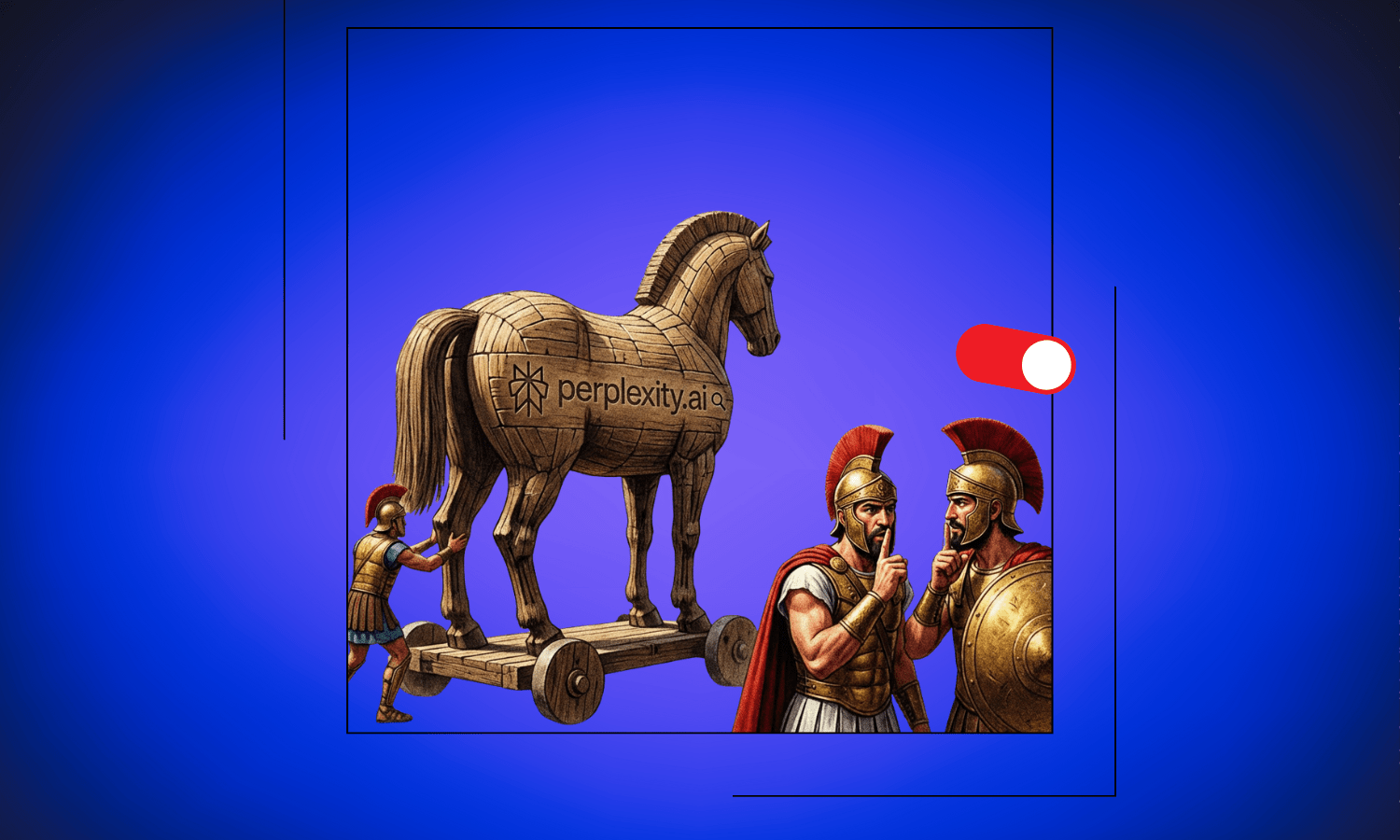

Schatten-KI beschreibt die unautorisierte Nutzung von Tools und Diensten der künstlichen Intelligenz durch Mitarbeiter ohne formelle Genehmigung, Aufsicht oder Wissen der IT-Abteilungen oder des Managements. Im Gegensatz zu genehmigten Unternehmens-KI-Systemen umfasst Schatten-KI Verbraucherplattformen wie ChatGPT, Gemini, Claude und Perplexity, die Mitarbeiter eigenständig nutzen, um ihre Produktivität zu steigern. Dabei teilen sie oft sensible Unternehmensdaten, Geschäftsgeheimnisse und vertrauliche Informationen mit Drittanbietern von KI, die diese Konversationen möglicherweise zum Trainieren ihrer Modelle verwenden.

Der Morgen beginnt wie jeder andere. Dein Marketing-Manager öffnet einen Browser-Tab und tippt eine Frage zur Positionierungsstrategie für euren kommenden Produktlaunch in ChatGPT ein. Dein Entwickler fügt Code in Claude ein, um ein kniffliges Problem zu debuggen. Dein Vertriebsmitarbeiter bittet Gemini, einen Entwurf für ein Angebot an euren größten Interessenten zu erstellen. Bis zum Mittagessen hat dein Finanzteam die Prognosen für dieses Quartal in ein KI-Tool hochgeladen, um Trends zu analysieren.

Keiner von ihnen hat um Erlaubnis gefragt. Keiner von ihnen hat darüber nachgedacht, wohin diese Daten gehen. Und niemandem ist klar, dass sie gerade die Wettbewerbsvorteile eures Unternehmens an Systeme weitergegeben haben, die darauf ausgelegt sind, aus jeder Interaktion zu lernen.

Willkommen bei der Schatten-KI, dem Phänomen, das die Art und Weise, wie Arbeit erledigt wird, neu gestaltet und gleichzeitig Sicherheitslücken schafft, von deren Existenz die meisten Organisationen nicht einmal wissen. Die gute Nachricht? Es gibt einen klaren Weg nach vorne, bei dem man sich nicht zwischen Produktivität und Datenschutz entscheiden muss – eine Lösung, die wir am Ende dieses Artikels erkunden werden.

Was Schatten-KI eigentlich bedeutet

Schatten-KI bezieht sich auf die unautorisierte Nutzung von Tools und Diensten der künstlichen Intelligenz durch Mitarbeiter ohne formelle Genehmigung, Aufsicht oder Wissen der IT-Abteilungen oder des Managements. Stell es dir als das KI-Äquivalent zur Schatten-IT vor, bei der Mitarbeiter Cloud-Dienste und Software nutzen, ohne die offiziellen Kanäle zu durchlaufen. Der Unterschied? Bei Schatten-KI geht es nicht nur um die Nutzung nicht genehmigter Software. Es geht darum, potenziell sensible Informationen in Systeme einzuspeisen, die aktiv aus deinen Eingaben lernen.

Die Zahlen erzählen eine deutliche Geschichte. Jüngste Studien zeigen, dass zwar die meisten Wissensarbeiter mittlerweile regelmäßig KI-Tools nutzen, um ihre Produktivität zu steigern, 70 % diese Nutzung jedoch aktiv vor ihren Arbeitgebern verheimlichen. Sie versuchen nicht, böswillig zu sein. Sie versuchen, effizient zu sein. Diese Tools sind kostenlos, leistungsstark und leicht zugänglich. Warum auf die Unternehmensfreigabe warten, wenn ChatGPT dir jetzt gleich helfen kann, diese E-Mail zu schreiben?

Aber diese Bequemlichkeit hat unsichtbare Haken.

Das Rennen zur AGI und warum deine Daten wichtig sind

Um zu verstehen, warum Schatten-KI ein so großes Risiko darstellt, musst du das ultimative Ziel von Unternehmen wie OpenAI, Google, Anthropic und anderen verstehen: Künstliche Allgemeine Intelligenz, kurz AGI (Artificial General Intelligence). AGI bezeichnet KI-Systeme, die Wissen in jedem Bereich auf oder über menschlichem Niveau verstehen, lernen und anwenden können. Im Gegensatz zur heutigen schmalen KI (Narrow AI), die sich auf bestimmte Aufgaben spezialisiert, würde AGI über allgemeine kognitive Fähigkeiten verfügen, die der menschlichen Intelligenz Konkurrenz machen.

Das Erreichen von AGI erfordert riesige Mengen an diversen, qualitativ hochwertigen Daten. Jede Unterhaltung, die du mit ChatGPT führst, jedes Dokument, das du auf Gemini hochlädst, jede Brainstorming-Sitzung, die du mit Claude durchführst, wird zu potenziellem Trainingsmaterial. Diese Unternehmen machen daraus kein Geheimnis. Ihre Nutzungsbedingungen besagen oft ausdrücklich, dass deine Interaktionen zur Verbesserung ihrer Modelle verwendet werden können.

Hier wird es bedenklich. Da KI immer leistungsfähiger wird, finden Nutzer immer ausgefeiltere Wege, diese Tools einzusetzen. Du beginnst mit einfachen Fragen und gehst dann zu komplexen Analysen, strategischer Planung, Codegenerierung und kreativer Problemlösung über. Jede dieser Entwicklungsstufen erzeugt neue Trainingsdaten, die die nächste KI-Generation noch leistungsfähiger machen, was wiederum eine noch komplexere Nutzung fördert. Es ist ein sich selbst verstärkender Kreislauf, der keine Anzeichen einer Verlangsamung zeigt.

Für KI-Unternehmen, die zur AGI eilen, sind deine Interaktionen nicht nur Kundenservice-Daten. Sie sind der Treibstoff für den nächsten Durchbruch. Je vielfältiger und anspruchsvoller der Input, desto wertvoller wird er. Und im Moment liefern Millionen von Arbeitnehmern diesen Treibstoff, ohne dass jemand den Überblick behält.

Das Unternehmensrisiko, über das niemand spricht

Für einzelne Nutzer sind die Auswirkungen auf den Datenschutz erheblich. Deine persönlichen Gedanken, kreativen Ideen und sogar lockere Gespräche werden Teil eines Trainingsdatensatzes, der weit außerhalb deiner Kontrolle existiert. Aber für Unternehmen stellt Schatten-KI eine existenzielle Bedrohung dar, die die meisten Führungsteams noch nicht vollständig begriffen haben.

Überlege, wofür Mitarbeiter KI-Tools typischerweise nutzen. Sie fragen nicht nur nach dem Wetter. Sie:

- Entwickeln Produktstrategien (Brainstorming)

- Analysieren Wettbewerbsinformationen

- Debuggen proprietären Code

- Entwerfen Kundenangebote

- Arbeiten Finanzprognosen durch

- Lösen komplexe Geschäftsprobleme

Mit anderen Worten: Sie teilen genau die Art von Informationen, die deinem Unternehmen seinen Wettbewerbsvorteil verschaffen.

Wenn dein Entwickler proprietären Code in ChatGPT einfügt, um ihn zu debuggen, könnte dieser Code theoretisch verwendet werden, um zukünftige Modelle zu trainieren. Wenn dein Marketingteam unveröffentlichte Produktfunktionen mit einem KI-Assistenten bespricht, werden diese Strategien Teil eines riesigen Datensatzes. Wenn dein Finanzteam interne Dokumente zur Analyse hochlädt, hast du im Grunde deine Zahlen an einen Dritten übergeben, dessen Nutzungsbedingungen seine eigenen KI-Entwicklungsziele priorisieren.

Die Ironie ist scharf. Dieselben Tools, die Mitarbeiter nutzen, um effizienter zu arbeiten und einen Wettbewerbsvorteil zu erzielen, könnten genau die Vorteile, die sie verstärken wollen, schleichend untergraben. Deine Innovation von heute wird morgen zum Standard für alle, wenn sie in das nächste Modell-Update einfließt.

Warum Mitarbeiter ihre KI-Nutzung verheimlichen

Zu verstehen, warum 70 % der Arbeitnehmer ihre KI-Nutzung verheimlichen, offenbart die Tiefe dieser Herausforderung. Es geht nicht nur darum, Regeln zu brechen. Es geht um eine grundlegende Diskrepanz zwischen der Art und Weise, wie Arbeit tatsächlich erledigt wird, und wie Organisationen denken, dass sie erledigt wird.

Soziales Stigma spielt eine große Rolle. Viele Mitarbeiter machen sich Sorgen, dass sie als weniger kompetent angesehen werden, wenn sie zugeben, KI-Unterstützung zu nutzen. Es gibt die Wahrnehmung, dass „echte“ Arbeit bedeutet, alles selbst zu machen, und dass die Nutzung von KI irgendwie Betrug ist oder eine Abkürzung darstellt. Manche fürchten, dass ihre Arbeitsplätze gefährdet sein könnten, wenn das Management erkennt, dass KI Teile ihrer Rolle übernehmen kann. Andere wollen sich schlichtweg nicht mit bürokratischen Genehmigungsprozessen herumschlagen, wenn sie sofort und eigenständig auf Tools zugreifen können.

Der Teufelskreis

Dies schafft einen Teufelskreis:

- Weil Mitarbeiter ihre Nutzung verheimlichen, entwickeln Unternehmen keine klaren Richtlinien.

- Weil es keine klaren Richtlinien gibt, wissen Mitarbeiter nicht, was akzeptabel ist.

- Weil sie nicht wissen, was akzeptabel ist, verheimlichen sie ihre Nutzung standardmäßig.

- Und währenddessen fließen sensible Daten ungehindert in Systeme, die darauf ausgelegt sind, daraus zu lernen.

Das Datenschutzproblem wird mit der Zeit größer

Die langfristigen Auswirkungen auf den Datenschutz gehen über den unmittelbaren Datenabfluss hinaus. Sobald Informationen in diese Trainingsdatensätze gelangen, ist es fast unmöglich, sie wieder zu entfernen. Selbst wenn ein Unternehmen das Risiko später erkennt und Richtlinien einführt, existieren die Daten aus Monaten oder Jahren der Schatten-KI-Nutzung bereits irgendwo im Trainingskorpus der großen KI-Modelle.

Bedenke die Entwicklung. Da Modelle immer ausgefeilter werden, entwickeln sie längere Kontextfenster (Context Windows) und bessere Speichersysteme. Zukünftige Versionen könnten in der Lage sein, Informationen über Millionen von Trainingsbeispielen hinweg abzurufen und zu synthetisieren. Die strategische Diskussion, die dein Team Anfang 2024 über die Marktpositionierung geführt hat, könnte theoretisch Antworten zu Branchentrends Jahre später beeinflussen. Dein proprietärer Algorithmus von 2025 könnte Code-Vorschläge im Jahr 2027 beeinflussen.

Die Unternehmen, die diese Modelle bauen, haben jeden Anreiz, so viele Daten wie möglich zu sammeln. Trainingsdaten sind die wertvollste Ressource im Wettlauf zur AGI, und sie bekommen sie kostenlos, jedes Mal, wenn jemand eine Anfrage tippt oder ein Dokument hochlädt. Sie tun nichts Illegales. Die Nutzer stimmen den Nutzungsbedingungen zu, wenn sie Konten erstellen. Aber die meisten Nutzer lesen diese Bedingungen nie und bedenken sicherlich nicht die langfristigen Auswirkungen für Daten, die sich wie eine flüchtige Unterhaltung anfühlen, aber zu permanentem Trainingsmaterial werden.

Was das für verschiedene Interessengruppen bedeutet

Für einzelne Fachkräfte

Die Nutzung von Schatten-KI schafft persönliche Datenschutzrisiken. Deine Karriereaspirationen, finanziellen Sorgen, Gesundheitsfragen und kreativen Ideen werden alle zu Datenpunkten. Dein Schreibstil, deine Problemlösungsansätze und deine Denkmuster werden analysiert und in Systeme integriert, über die du keine Kontrolle hast.

Für kleine Unternehmen und Startups

Die Risiken sind besonders akut. Diese Organisationen operieren oft mit hauchdünnen Vorteilen. Ein neuartiger Ansatz im Kundenservice, eine innovative Produktfunktion oder eine einzigartige Markteinsicht könnten ihr einziger Vorteil gegenüber größeren Konkurrenten sein. Diesen durch schleichenden Datenabfluss zu verlieren, könnte verheerend sein, und sie erfahren vielleicht nie, dass es passiert ist.

Für Großunternehmen (Enterprises)

Schatten-KI stellt sowohl ein Governance-Versagen als auch eine Sicherheitslücke dar. Sie schafft blinde Flecken in Systemen zur Verhinderung von Datenverlust (DLP), umgeht Informationssicherheitsprotokolle und macht sorgfältige Compliance-Rahmenwerke zur Farce. Regulierte Branchen stehen vor zusätzlichen Problemen, da Mitarbeiter versehentlich Informationen, die der DSGVO (GDPR), HIPAA oder anderen Datenschutzbestimmungen unterliegen, mit Systemen teilen könnten, die unter anderen Rechtsordnungen und rechtlichen Rahmenbedingungen operieren.

Der Weg nach vorne

Die Lösung des Schatten-KI-Problems erfordert mehr als bloße Verbote. Das Verbieten von KI-Tools wird nicht funktionieren, wenn sie so nützlich und zugänglich sind. Mitarbeiter werden Wege finden, Einschränkungen zu umgehen, was das Problem nur noch weiter in den Untergrund treibt. Stattdessen müssen Organisationen die Türen für datenschutzfreundliche Alternativen öffnen, die den Mitarbeitern die benötigten KI-Fähigkeiten geben, ohne die Risiken der Datensammlung.

Schlüsselstrategien

1. Genehmigte Alternativen bereitstellen Der klügste Ansatz ist es, genehmigte Alternativen bereitzustellen, die den Datenschutz standardmäßig respektieren. Lösungen wie CamoCopy Enterprise machen es für Mitarbeiter einfacher, sanktionierte KI-Tools zu nutzen, anstatt Workarounds zu finden, um auf verbotene Systeme zuzugreifen. Wenn der einfachste Weg auch der sicherste ist, nimmt Schatten-KI ganz natürlich ab.

2. Aufklärung Die meisten Mitarbeiter verstehen wirklich nicht, wohin ihre Daten gehen oder wie KI-Training funktioniert. Sie sehen diese Tools als einfache Frage-Antwort-Systeme, nicht als ausgefeilte Datensammlungsmechanismen, die das Rennen zur AGI füttern. Klare Kommunikation über Risiken hilft Arbeitnehmern, informierte Entscheidungen zu treffen.

3. Klare Richtlinien Mitarbeiter müssen wissen, was akzeptabel ist, was verboten ist und warum. Grauzonen züchten Schatten-Nutzung. Spezifische Anleitungen zu verschiedenen Arten von Informationen und angemessenen Anwendungsfällen geben den Leuten Leitplanken, denen sie tatsächlich folgen können.

4. Laufender Dialog KI-Fähigkeiten entwickeln sich rasant. Richtlinien von vor sechs Monaten adressieren möglicherweise nicht die aktuellen Risiken oder Chancen. Regelmäßige Gespräche über KI-Nutzung, Risiken und Vorteile reduzieren das Stigma, das heimliches Verhalten antreibt.

Die ‘Privacy-First’-Alternative

Das grundlegende Problem bei Schatten-KI ist nicht, dass Mitarbeiter produktiver sein wollen. Es ist, dass die zugänglichsten KI-Tools ihren eigenen Fortschritt über die Privatsphäre der Nutzer stellen. Solange die einfachste Option auch die riskanteste ist, wird Schatten-KI bestehen bleiben.

Hier kommen Privacy-First KI-Assistenten ins Spiel. Tools, die sich ausdrücklich dazu verpflichten, niemals mit Nutzerdaten zu trainieren, die unter starken Datenschutzrahmenbedingungen operieren und die Nutzerkontrolle an erste Stelle setzen, bieten einen Ausweg aus der Schatten-KI-Falle. Datenschutzorientierte Alternativen wie CamoCopy haben diesen Ansatz seit Ende 2022 vorangetrieben und gezeigt, dass leistungsstarke KI-Assistenz und starker Datenschutz sich nicht gegenseitig ausschließen.

Die Technologie existiert. Die Alternative existiert. Was jetzt benötigt wird, ist das Bewusstsein, dass Schatten-KI nicht nur ein IT-Richtlinien-Thema ist, sondern eine fundamentale Frage zu Dateneigentum, Wettbewerbsvorteil und der Zukunft der Arbeit in einer KI-gesteuerten Welt.

Die Entscheidung liegt bei dir

Wenn dein Team bereits KI-Tools nutzt – und statistisch gesehen tun sie das fast sicher –, ist die Frage nicht, ob man sich mit KI beschäftigt. Die Frage ist, ob diese Beschäftigung im Schatten stattfindet und das Rennen zur AGI mit deinen sensibelsten Informationen füttert, oder im Licht, mit Tools, die darauf ausgelegt sind, deine Privatsphäre zu respektieren, während sie die Fähigkeiten liefern, die du brauchst.

Für Organisationen und Einzelpersonen, die bereit sind, KI zu nutzen, ohne den Datenschutz zu opfern, bietet CamoCopy eine klare Alternative, die auf ‘Privacy by Default’ (Datenschutz als Standard) aufbaut. Im Gegensatz zu Mainstream-KI-Plattformen gilt bei CamoCopy:

- Es wird niemals mit deinen Konversationen trainiert

- Deine Dokumente und Bilder werden verschlüsselt

- Deine Datensicherheit steht an erster Stelle, anstatt deine Interaktionen als Rohmaterial für Modellverbesserungen zu behandeln

Die Wahl liegt bei dir, aber die Uhr tickt, während die Schatten-KI ihre unsichtbare Ausbreitung fortsetzt.