Qu'est-ce que le Shadow AI ? Pourquoi c'est un problème majeur et comment le résoudre

De ChatGPT à Gemini, les outils d'IA redéfinissent le travail. Mais à quel prix pour la confidentialité et la sécurité ?

Qu’est-ce que le Shadow AI ? Définition rapide

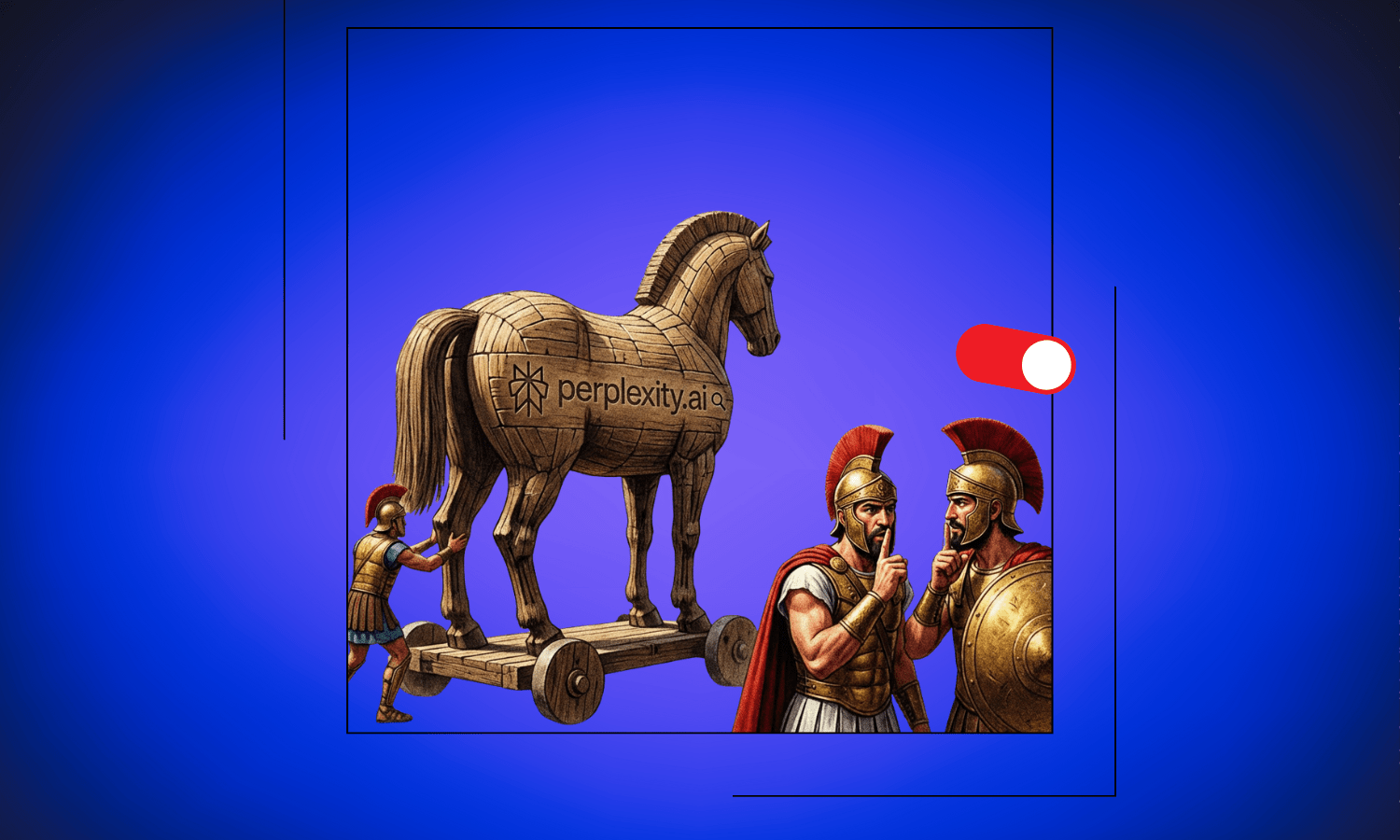

Le Shadow AI (ou IA de l’ombre) décrit l’utilisation non autorisée d’outils et de services d’intelligence artificielle par les employés sans l’approbation formelle, la supervision ou la connaissance des départements informatiques ou de la direction. Contrairement aux systèmes d’IA d’entreprise approuvés, le Shadow AI inclut des plateformes grand public comme ChatGPT, Gemini, Claude et Perplexity que les travailleurs utilisent indépendamment pour augmenter leur productivité, partageant souvent des données sensibles de l’entreprise, des secrets commerciaux et des informations confidentielles avec des fournisseurs d’IA tiers, qui peuvent utiliser ces conversations pour entraîner leurs modèles.

La matinée commence comme n’importe quelle autre. Votre responsable marketing ouvre un onglet de navigateur et tape une question dans ChatGPT sur la stratégie de positionnement pour votre prochain lancement de produit. Votre développeur colle du code dans Claude pour déboguer un problème complexe. Votre commercial demande à Gemini de l’aider à rédiger une proposition pour votre plus gros prospect. À l’heure du déjeuner, votre équipe financière a téléchargé les prévisions du trimestre dans un outil d’IA pour analyser les tendances.

Aucun d’entre eux n’a demandé la permission. Aucun d’entre eux n’a réfléchi à la destination de ces données. Et aucun d’entre eux ne réalise qu’il vient de livrer l’intelligence concurrentielle de votre entreprise à des systèmes conçus pour apprendre de chaque interaction.

Bienvenue dans l’ère du Shadow AI, le phénomène qui remodèle la façon dont le travail est effectué tout en créant des angles morts de sécurité dont la plupart des organisations ignorent même l’existence. La bonne nouvelle ? Il existe une voie claire qui ne nécessite pas de choisir entre productivité et confidentialité, une solution que nous explorerons à la fin de cet article.

Ce que signifie réellement le Shadow AI

Le Shadow AI fait référence à l’utilisation non autorisée d’outils et de services d’intelligence artificielle par les employés sans approbation formelle, supervision ou connaissance des services informatiques ou de la direction. Pensez-y comme l’équivalent IA du “Shadow IT” (informatique de l’ombre), où les travailleurs adoptent des services cloud et des logiciels sans passer par les canaux officiels. La différence ? Le Shadow AI ne concerne pas seulement l’utilisation de logiciels non approuvés. Il s’agit d’alimenter des informations potentiellement sensibles dans des systèmes qui apprennent activement de vos entrées.

Les chiffres racontent une histoire éloquente. Des études récentes montrent que si la plupart des travailleurs du savoir utilisent désormais régulièrement des outils d’IA pour augmenter leur productivité, 70 % dissimulent activement cette utilisation à leurs employeurs. Ils n’essaient pas d’être malveillants. Ils essaient d’être efficaces. Ces outils sont gratuits, puissants et facilement accessibles. Pourquoi attendre une approbation de l’entreprise quand ChatGPT peut vous aider à rédiger cet e-mail dès maintenant ?

Mais cette commodité s’accompagne de conditions invisibles.

La course à l’IAG et pourquoi vos données comptent

Pour comprendre pourquoi le Shadow AI pose un risque si important, vous devez comprendre l’objectif ultime qui motive des entreprises comme OpenAI, Google, Anthropic et d’autres : l’Intelligence Artificielle Générale, ou IAG. L’IAG fait référence à des systèmes d’IA capables de comprendre, d’apprendre et d’appliquer des connaissances dans n’importe quel domaine à un niveau égal ou supérieur à celui de l’humain. Contrairement à l’IA étroite d’aujourd’hui qui excelle dans des tâches spécifiques, l’IAG posséderait des capacités cognitives générales rivalisant avec l’intelligence humaine.

Atteindre l’IAG nécessite des quantités massives de données diverses et de haute qualité. Chaque conversation que vous avez avec ChatGPT, chaque document que vous téléchargez sur Gemini, chaque séance de brainstorming que vous menez avec Claude devient un matériel d’entraînement potentiel. Ces entreprises ne s’en cachent pas. Leurs conditions d’utilisation indiquent souvent explicitement que vos interactions peuvent être utilisées pour améliorer leurs modèles.

C’est là que cela devient préoccupant. À mesure que l’IA devient plus performante, les utilisateurs trouvent des moyens de plus en plus sophistiqués d’utiliser ces outils. Vous commencez par des questions simples, puis passez à l’analyse complexe, à la planification stratégique, à la génération de code et à la résolution créative de problèmes. Chaque évolution crée de nouvelles données d’entraînement qui rendent la prochaine génération d’IA encore plus capable, ce qui encourage une utilisation encore plus complexe. C’est un cycle auto-renforcé qui ne montre aucun signe de ralentissement.

Pour les entreprises d’IA qui font la course vers l’IAG, vos interactions ne sont pas seulement des données de service client. Elles sont le carburant de la prochaine percée. Plus l’entrée est diverse et sophistiquée, plus elle devient précieuse. Et en ce moment, des millions de travailleurs fournissent ce carburant sans que personne ne surveille.

Le risque d’entreprise dont personne ne parle

Pour les utilisateurs individuels, les implications pour la vie privée sont importantes. Vos pensées personnelles, vos idées créatives et même vos conversations informelles font partie d’un ensemble de données d’entraînement qui existe bien au-delà de votre contrôle. Mais pour les entreprises, le Shadow AI représente une menace existentielle que la plupart des équipes de direction n’ont pas encore pleinement saisie.

Considérez ce pour quoi les employés utilisent généralement les outils d’IA. Ils ne demandent pas simplement la météo. Ils :

- Brainstorment des stratégies produits

- Analysent la veille concurrentielle

- Déboguent du code propriétaire

- Rédigent des propositions clients

- Travaillent sur des projections financières

- Résolvent des problèmes commerciaux complexes

En d’autres termes, ils partagent exactement le type d’informations qui donne à votre entreprise son avantage concurrentiel.

Lorsque votre développeur colle du code propriétaire dans ChatGPT pour le déboguer, ce code pourrait théoriquement être utilisé pour entraîner de futurs modèles. Lorsque votre équipe marketing discute de fonctionnalités de produits non publiées avec un assistant IA, ces stratégies deviennent partie intégrante d’un vaste ensemble de données. Lorsque votre équipe financière télécharge des documents internes pour analyse, vous avez essentiellement remis vos chiffres à un tiers dont les conditions d’utilisation priorisent ses propres objectifs de développement d’IA.

L’ironie est mordante. Les mêmes outils que les employés utilisent pour travailler plus efficacement et gagner un avantage concurrentiel pourraient éroder progressivement les avantages mêmes qu’ils tentent d’amplifier. Votre innovation d’aujourd’hui devient la norme de demain pour tout le monde lorsqu’elle filtre dans la prochaine mise à jour du modèle.

Pourquoi les employés cachent leur utilisation de l’IA

Comprendre pourquoi 70 % des travailleurs cachent leur utilisation de l’IA révèle la profondeur de ce défi. Il ne s’agit pas seulement d’enfreindre les règles. Il s’agit d’un décalage fondamental entre la façon dont le travail est réellement effectué et la façon dont les organisations pensent qu’il est effectué.

La stigmatisation sociale joue un rôle majeur. De nombreux employés craignent d’être perçus comme moins compétents s’ils admettent utiliser une assistance IA. Il existe une perception selon laquelle le “vrai” travail signifie tout faire soi-même, que l’utilisation de l’IA est en quelque sorte de la triche ou un raccourci. Certains craignent que leur emploi ne soit menacé si la direction réalise que l’IA peut effectuer des parties de leur rôle. D’autres ne veulent tout simplement pas faire face aux processus d’approbation bureaucratiques lorsqu’ils peuvent accéder instantanément aux outils par eux-mêmes.

Le cercle vicieux

Cela crée un cercle vicieux :

- Parce que les employés cachent leur utilisation, les entreprises ne développent pas de politiques claires.

- Parce qu’il n’y a pas de politiques claires, les employés ne savent pas ce qui est acceptable.

- Parce qu’ils ne savent pas ce qui est acceptable, ils choisissent par défaut de cacher leur utilisation.

- Et pendant ce temps, les données sensibles circulent librement vers des systèmes conçus pour apprendre d’elles.

Le problème de confidentialité s’aggrave avec le temps

Les implications à long terme pour la confidentialité s’étendent au-delà de la fuite de données immédiate. Une fois que les informations entrent dans ces ensembles de données d’entraînement, il devient presque impossible de les supprimer. Même si une entreprise réalise plus tard le risque et met en œuvre des politiques, les données provenant de mois ou d’années d’utilisation du Shadow AI existent déjà quelque part dans le corpus d’entraînement des grands modèles d’IA.

Considérez la trajectoire. À mesure que les modèles deviennent plus sophistiqués, ils développent des fenêtres contextuelles plus longues et de meilleurs systèmes de mémoire. Les futures versions pourraient être capables de rappeler et de synthétiser des informations à travers des millions d’exemples d’entraînement. La discussion stratégique que votre équipe a eue sur le positionnement du marché début 2024 pourrait théoriquement informer des réponses sur les tendances de l’industrie des années plus tard. Votre algorithme propriétaire de 2025 pourrait influencer les suggestions de code en 2027.

Les entreprises qui construisent ces modèles ont tout intérêt à collecter autant de données que possible. Les données d’entraînement sont la ressource la plus précieuse dans la course à l’IAG, et elles l’obtiennent gratuitement chaque fois que quelqu’un tape une requête ou télécharge un document. Elles ne font rien d’illégal. Les utilisateurs acceptent les conditions d’utilisation lorsqu’ils créent des comptes. Mais la plupart des utilisateurs ne lisent jamais ces conditions, et ils ne considèrent certainement pas les implications à long terme pour des données qui semblent conversationnelles et temporaires, mais qui deviennent un matériel d’entraînement permanent.

Ce que cela signifie pour les différentes parties prenantes

Pour les professionnels individuels

L’utilisation du Shadow AI crée des risques personnels pour la vie privée. Vos aspirations professionnelles, vos préoccupations financières, vos questions de santé et vos idées créatives deviennent toutes des points de données. Votre style d’écriture, vos approches de résolution de problèmes et vos schémas de pensée sont analysés et intégrés dans des systèmes sur lesquels vous n’avez aucun contrôle.

Pour les petites entreprises et les startups

Les risques sont particulièrement aigus. Ces organisations opèrent souvent avec des avantages très minces. Une approche nouvelle du service client, une fonctionnalité de produit innovante ou une vision unique du marché pourrait être leur seul atout contre de plus grands concurrents. Perdre cela par une fuite progressive de données pourrait être dévastateur, et elles pourraient ne jamais savoir que cela s’est produit.

Pour les grandes entreprises

Le Shadow AI représente à la fois un échec de gouvernance et une vulnérabilité de sécurité. Il crée des angles morts dans les systèmes de prévention des pertes de données (DLP), contourne les protocoles de sécurité de l’information et tourne en dérision les cadres de conformité rigoureux. Les industries réglementées font face à des préoccupations supplémentaires, car les employés pourraient partager par inadvertance des informations soumises au RGPD, à l’HIPAA ou à d’autres réglementations de confidentialité avec des systèmes qui opèrent sous des juridictions et des cadres juridiques différents.

La voie à suivre

Résoudre le défi du Shadow AI nécessite d’aller au-delà de la simple interdiction. Bannir les outils d’IA ne fonctionnera pas alors qu’ils sont si utiles et accessibles. Les employés trouveront des moyens de contourner les restrictions, poussant le problème encore plus loin dans la clandestinité. Au lieu de cela, les organisations doivent ouvrir la porte à des alternatives respectueuses de la vie privée qui donnent aux employés les capacités d’IA dont ils ont besoin sans les risques de collecte de données.

Stratégies clés

1. Fournir des alternatives approuvées L’approche la plus intelligente consiste à fournir des alternatives approuvées qui respectent la confidentialité par défaut. Des solutions comme CamoCopy Enterprise permettent aux employés d’utiliser plus simplement des outils d’IA sanctionnés plutôt que de trouver des contournements pour accéder à des systèmes bannis. Lorsque le chemin le plus facile est aussi le chemin le plus sûr, le Shadow AI diminue naturellement.

2. Éducation La plupart des employés ne comprennent vraiment pas où vont leurs données ni comment fonctionne l’entraînement de l’IA. Ils voient ces outils comme de simples systèmes de questions-réponses, et non comme des mécanismes sophistiqués de collecte de données alimentant la course à l’IAG. Une communication claire sur les risques aide les travailleurs à prendre des décisions éclairées.

3. Politiques claires Les employés doivent savoir ce qui est acceptable, ce qui est interdit et pourquoi. Les zones grises engendrent l’utilisation fantôme. Des directives spécifiques sur les différents types d’informations et les cas d’utilisation appropriés donnent aux gens des garde-fous qu’ils peuvent réellement suivre.

4. Dialogue continu Les capacités de l’IA évoluent rapidement. Les politiques d’il y a six mois pourraient ne pas répondre aux risques ou opportunités actuels. Des conversations régulières sur l’utilisation de l’IA, les risques et les avantages réduisent la stigmatisation qui conduit au comportement secret.

L’alternative “Privacy-First”

Le problème fondamental avec le Shadow AI n’est pas que les employés veulent être plus productifs. C’est que les outils d’IA les plus accessibles priorisent leur propre avancement sur la confidentialité des utilisateurs. Tant que l’option la plus facile est aussi l’option la plus risquée, le Shadow AI persistera.

C’est là que les assistants IA axés sur la confidentialité entrent en jeu. Les outils qui s’engagent explicitement à ne jamais s’entraîner sur les données des utilisateurs, qui opèrent sous des cadres de confidentialité solides et qui placent le contrôle de l’utilisateur en premier offrent une issue au piège du Shadow AI. Des alternatives axées sur la confidentialité comme CamoCopy ont été les pionnières de cette approche depuis fin 2022, démontrant qu’une assistance IA puissante et de fortes protections de la confidentialité ne sont pas mutuellement exclusives.

La technologie existe. L’alternative existe. Ce qui est nécessaire maintenant, c’est la prise de conscience que le Shadow AI n’est pas seulement un problème de politique informatique, mais une question fondamentale sur la propriété des données, l’avantage concurrentiel et l’avenir du travail dans un monde piloté par l’IA.

Le choix vous appartient

Si votre équipe utilise déjà des outils d’IA, et statistiquement parlant, c’est presque certainement le cas, la question n’est pas de savoir s’il faut s’engager avec l’IA. La question est de savoir si cet engagement se fait dans l’ombre, alimentant la course à l’IAG avec vos informations les plus sensibles, ou dans la lumière, avec des outils conçus pour respecter votre vie privée tout en offrant les capacités dont vous avez besoin.

Pour les organisations et les individus prêts à adopter l’IA sans sacrifier la confidentialité, CamoCopy offre une alternative claire basée sur la confidentialité par défaut. Contrairement aux plateformes d’IA grand public, CamoCopy :

- Ne s’entraîne jamais sur vos conversations

- Chiffre vos documents et images

- Place la sécurité de vos données en premier plutôt que de traiter vos interactions comme de la matière première pour l’amélioration du modèle